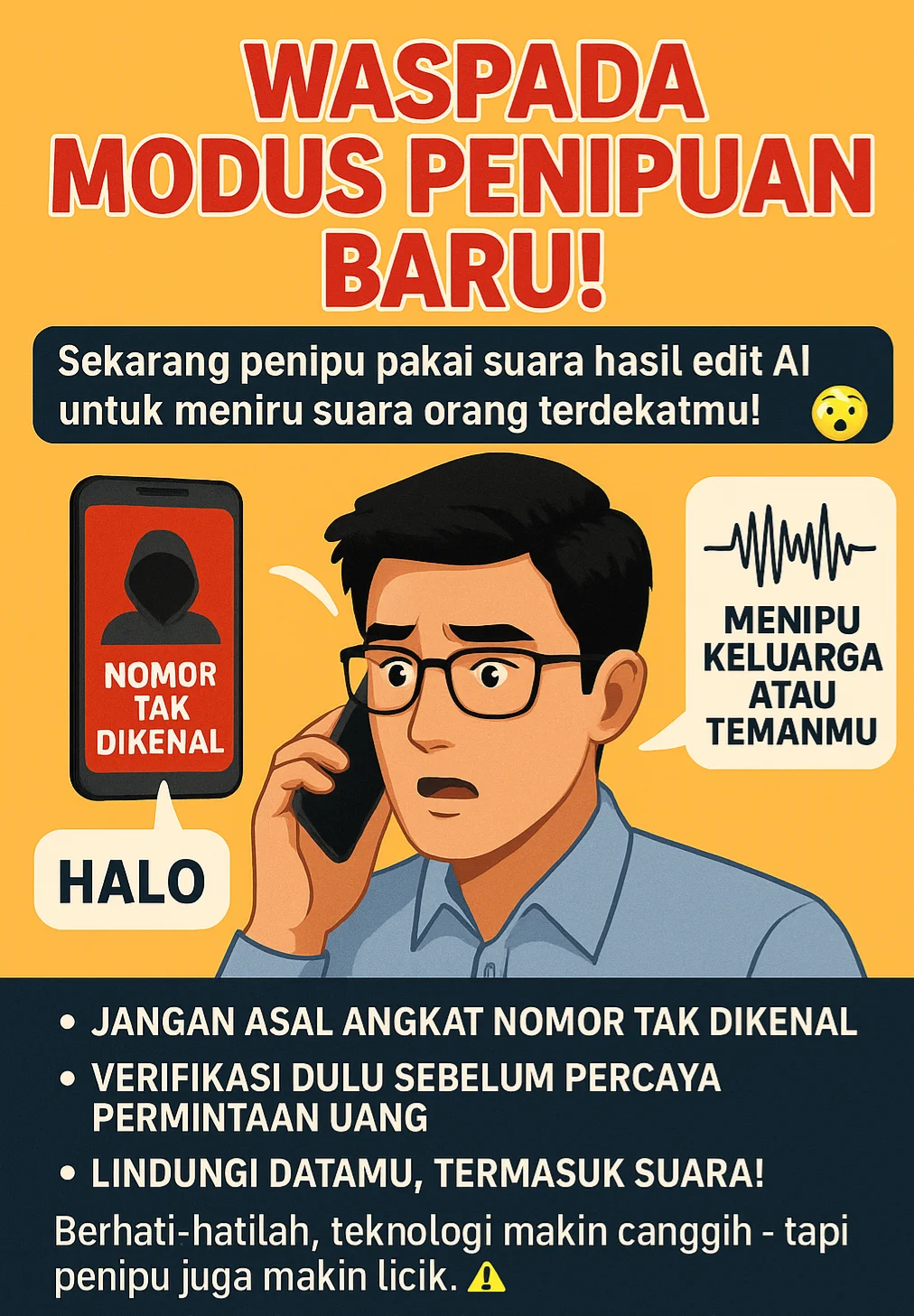

Waspada! Muncul Modus Penipuan Baru, Suara Korban Direkam dan Disalahgunakan Pakai Teknologi AI

Sumber: suaranuswa.com

Jakarta — Masyarakat diimbau untuk waspada terhadap modus penipuan baru yang kini marak beredar di berbagai daerah. Modus ini memanfaatkan teknologi kecerdasan buatan (AI) untuk meniru suara korban dan digunakan dalam aksi penipuan terhadap orang-orang terdekatnya.

Informasi yang dibagikan oleh akun Instagram @lambegosiip dan sejumlah sumber lain menyebutkan, pelaku biasanya menelpon korban menggunakan nomor tak dikenal. Saat korban menjawab dan mengucapkan kata sederhana seperti “halo”, suara tersebut direkam, kemudian diproses menggunakan teknologi AI untuk membuat tiruan suara yang sangat mirip dengan aslinya.

Setelah itu, pelaku akan menghubungi keluarga atau teman korban, berpura-pura sebagai korban dengan suara tiruan itu, dan meminta uang atau bantuan darurat.

Pihak kepolisian, melalui Ditreskrimsus Polda Sulteng, mengingatkan masyarakat agar berhati-hati terhadap panggilan dari nomor asing. “Jangan mudah merespons panggilan tak dikenal, apalagi jika setelahnya diminta melakukan transfer uang,” imbau salah satu perwakilan Ditreskrimsus.

Para ahli keamanan digital juga menyarankan agar masyarakat tidak mengunggah terlalu banyak rekaman suara di media sosial, karena bisa dimanfaatkan untuk pelatihan model suara oleh pihak tak bertanggung jawab.

Dengan semakin canggihnya teknologi, kehati-hatian menjadi kunci. Bijak dalam menerima telepon, dan selalu verifikasi langsung melalui cara lain jika ada permintaan mencurigakan dari orang yang mengaku sebagai kerabat.

—

Reporter: Tim Redaksi Suaranuswa.com

Editor: Andrea